Chat GPT egner seg dårlig til eksamenssensuren

Å spare tid må ikke gå på bekostning av den akademiske redeligheten.

KRONIKK AV PIERRE LISON, SENIORFORSKER I MASKINLÆRING OG SPRÅKTEKNOLOGI VED NORSK REGNESENTRAL OG FØRSTEAMANUENSIS II, UNIVERSITETET I OSLO OG SAMIA TOUILEB, FORSKER VED MEDIAFUTURES, UNIVERSITETET I BERGEN. Første gang publisert i Morgenbladet 14.07.23.

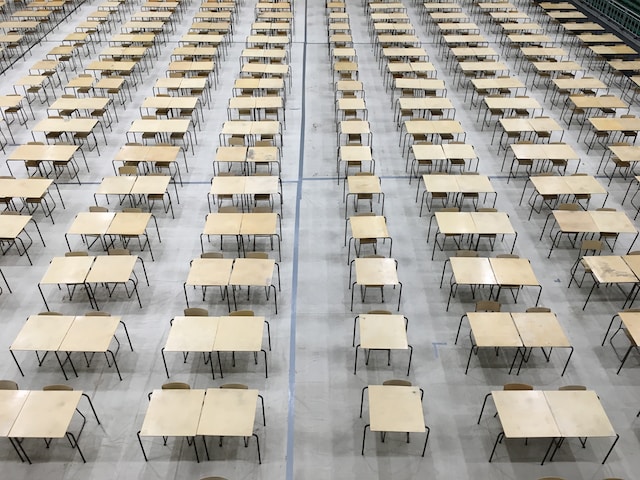

For et par uker siden kunne vi lese i VG om en lektor ved Høyskolen Kristiania som tok i bruk en språkmodell for å sensurere hovedoppgaver. Vi er to KI-forskere som jobber daglig med språkmodeller og maskinlæring, og har en klar oppfordring til våre kollegaer som kunne la seg inspirere til å gjøre det samme for å spare tid: Ikke gjør det.

Språkmodeller som ChatGPT driftes av eiere i USA

Det er flere grunner til dette. Den første er juridisk: Språkmodeller som for eksempel Chat GPT driftes av store kommersielle aktører og kjører vanligvis på servere i USA. Studentene har ikke samtykket til å få sine eksamensoppgaver overlevert til en tredjepart. Som det blir slått fast i retningslinjer fra Utdanningsdirektoratet, må eksamensbesvarelser anses som personopplysninger, selv når personidentifiserende opplysninger som navn ikke står på kopien. Å bruke slike tjenester uten studentenes samtykke utgjør derfor et brudd på personopplysningsloven.

Språkmodeller som ChatGPT er ikke verdinøytrale verktøy

Men om språkmodeller var godt egnet til å drive med sensurarbeid, kunne vi sikkert finne en løsning på denne hindringen. Det er imidlertid ikke tilfellet. Språkmodeller gjør ikke noe annet enn å gjenkjenne og gjengi språklige mønstre. En språkmodell som Chat GPT kan bli spurt om hvorvidt en eksamensbesvarelse stemmer overens med fasiten, men modellens resonneringsevner er begrenset og utsatt for feil. Hva om studenten finner en annen måte å besvare spørsmålet på enn det sensoren hadde sett for seg? Ettersom språkmodellen ikke har tilgang til kursets pensum, vil «vurderingen» basere seg på overfladiske likhetstrekk mellom studentens svar og fasiten, i stedet for å overveie hvorvidt vedkommende har tilegnet seg kursets kompetansemål.

Språkmodeller er heller ikke verdinøytrale verktøy. De er trent på gigantiske mengder tekster samlet inn fra nettet, og inkluderer dermed en god del fordomsfulle, løgnaktige eller hatefulle ytringer. Disse kan dessverre påvirke språkmodeller. Flere studier har vist at språkmodeller kan gjengi stereotypier og forutinntatte holdninger, noe som kan prege hvordan modellene bedømmer eksamensbesvarelser. En student som skriver på nynorsk, eller som ikke har norsk som morsmål, risikerer å få sin besvarelse vurdert annerledes enn sine medstudenter – selv når svaret er riktig.

Viktig å kjenne til språkteknologiens begrensninger

Det største problemet er likevel signaleffekten slike sensureringsmetoder kan ha på læringsprosessen. Språkmodeller opphøyer nemlig form over innhold. De er mestere i å fange opp språklige mønstre, men sliter med mer abstrakte ferdigheter som dybdeforståelse og resonneringsevne. Studenter er kjent for å være pragmatiske: De tilpasser seg det som skal til for å få en god karakter. Å bruke språkmodeller til å sensurere vil derfor oppmuntre studenter til å satse på mer overfladiske læringsmål, slik som å pugge formuleringer og nøkkelord, i stedet for å prioritere mer langsiktige læringsutbytter.

Det betyr selvsagt ikke at språkmodeller ikke bør tas i bruk i utdanning. De er svært nyttige verktøy for å bearbeide tekster, og vil uten tvil føre til viktige innovasjoner i sektoren.

Men det er minst like viktig å kjenne til teknologiens begrensninger og egnethet. Å spare tid må ikke gå på bekostning av den akademiske redeligheten.