Marin bildeanalyse

- Avdeling BAMJO

- Involverte fagområder Bildeanalyse, Maskinlæring

En stor mengde observasjonsdata samles i dag inn fra marin sektor med ulike typer sensorer. Det kan dreie seg om akustiske data fra ekkolodd, bilder og video fra havbunn eller trål, fly eller dronebilder av sjøpattedyr, eller ulike typer av bilder fra mikroskop.

Dataene inneholder verdifull informasjon som er viktig for overvåking av bestander og økosystemet i havet. En stadig økende mengde av slike data gjør manuell analyse til en alvorlig flaskehals, mens tidligere automatiske metoder ikke har gitt tilstrekkelig kvalitet.

Nyere metoder basert på dyp læring gir nå en mulighet for å forbedre dette, men relatert til marine data er det utfordringer knyttet til at bildedataene er komplekse og treningsdata er begrenset. I samarbeid med Havforskningsinstituttet jobber vi derfor med å utvikle og tilpasse metoder basert på dyp læring som kan bidra til bedre og mer effektiv uttrekking av informasjon fra ulike typer av marine bildedata.

Gjennom IKTpluss-prosjektet Cogmar (2017-2022) er det utviklet en metode basert på dyp læring for deteksjon og klassifikasjon av tobis (sandeel) fra akustiske data (venstre bilde).

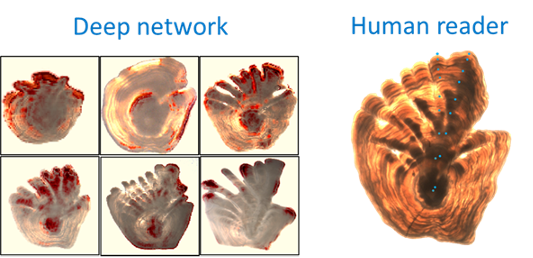

Det er også gjort en studie på hva et nevralt nettverk for prediksjon av fiskens alder fra bilder av ørestein (otolitter) fokuserer på for ulike aldersgrupper av fisk (høyre bilde).

Problemstillinger knyttet til maskinlæring av akustiske data vil nå framover også være sentrale i arbeid vi gjør innenfor Havforskningsinstituttets senter for forskningsbasert innovasjon, CRIMAC (2020-2028) – Center for Research-based Innovation in Marine Acoustic Abundance Estimation and Backscatter Classification. Samtidig er videreutvikling av metodikk for dyp læring for marin sektor også et viktig tema innenfor vårt arbeid i Visual Intelligence (2020-2028), et senter for forskningsdrevet innovasjon med fokus på AI og dyp læring for komplekse bildedata som ledes av Universitetet i Tromsø i samarbeid med Norsk Regnesentral og Universitetet i Oslo.